开始遨游CVPR2017,主要是为了学习更多的深度学习网络架构

讲道理计算机视觉的深度学习架构是深度学习各领域比较先进的,比如CNN,自编码器,GAN,注意力机制都是出于CV然后应用于其他领域的。所以即使我不学CV了还是要看CVPR的论文

论文本身

讨论一下GAN的缺点:

Mode Collapse:当GAN无法达到识别网络D每趟的运行次数大于生成网络G的时候,生成网络生成的所有内容都将归于同样的对象,比如训练GAN for MNIST最后所有的生成内容都为1

训练速度慢,训练吃数据:原始GAN的生成网络与识别网络都是MLP(不是很懂为什么)。较CNN来说,MLP更吃数据而且运行速度更慢

GAN生成数据的多样性来自于GAN的生成者输入的噪音N。原始GAN的噪音是高斯噪音。而这篇文章主要的重点,笔者认为在于尝试去用一个有点想Batch Normalization的方式去学习噪声输入

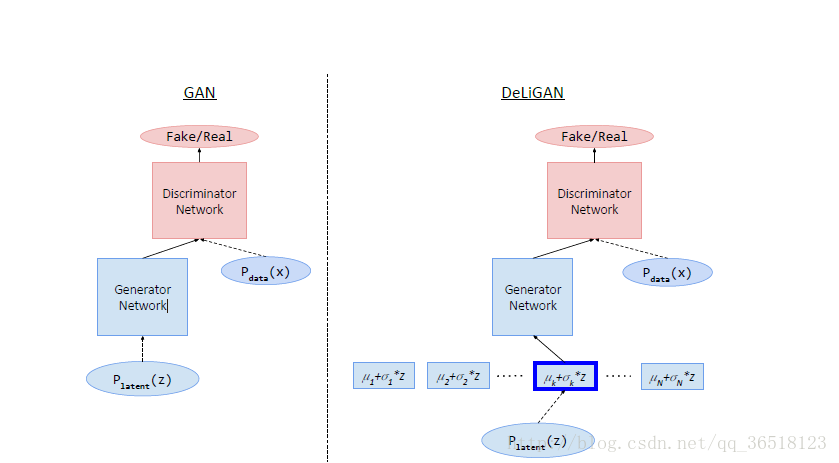

图右就是DeLiGAN的结构。可以看到,DeLiGAN在输入的时候进行了变化。

DeLiGAN使输入噪音通过一个高斯混合模型(Mixture-of-Gaussian model)

$$p_z(z) = \sum_{i=1}^N\phi_ig(z|\mu_i, \Sigma)$$

其中$\phi_i$是权值,也是采用重参数单元(我使用的是指的是$g(z|\mu_i, \Sigma)$ )的概率。在文章中$\phi$ 使用的是uniform概率,即原公式变为

$p_z(z) = \sum_{i=1}^N\frac{g(z|\mu_i, \Sigma)}{N}$

我们随机的从N个重参数单元中选取一个,每一个选取概率相同

假设第$i$个单元被选择。我们将输入重新定义为

$z = \mu_i+\sigma_i \epsilon where \epsilon \sim N(0, 1)$

将其代入GAN的模型,可以将原模型变为:

$p_{data}(G(z))=\sum_{i=1}^N\int\frac{p_{data}(G(\mu_i+\sigma_i\epsilon |\epsilon))p(\epsilon)d\epsilon}{N}$

其中$\mu$ 和$\sigma$ 都是应该学习的参数

3.学习$\mu$与$\sigma$

notice:作者说明为什么不试着在单元的地方使用权值参数:因为无法正常训练,无法得到权值的梯度

由于$p_{data}(G(z))$在$\mu_i$处有局部最小值,所以当G优化$\sigma$ 的时候,$\sigma$可以小于0。为了避免这个,我们尝试在GAN网络 基础上用L2正则化

$max_GV_G(D, G)=min_G\mathbb{E}_{z\sim p_z}[log(1-D(G(z)))]+\lambda\sum_{i=1}^N\frac{(1-\sigma_i)^2}{N}$

- 实验

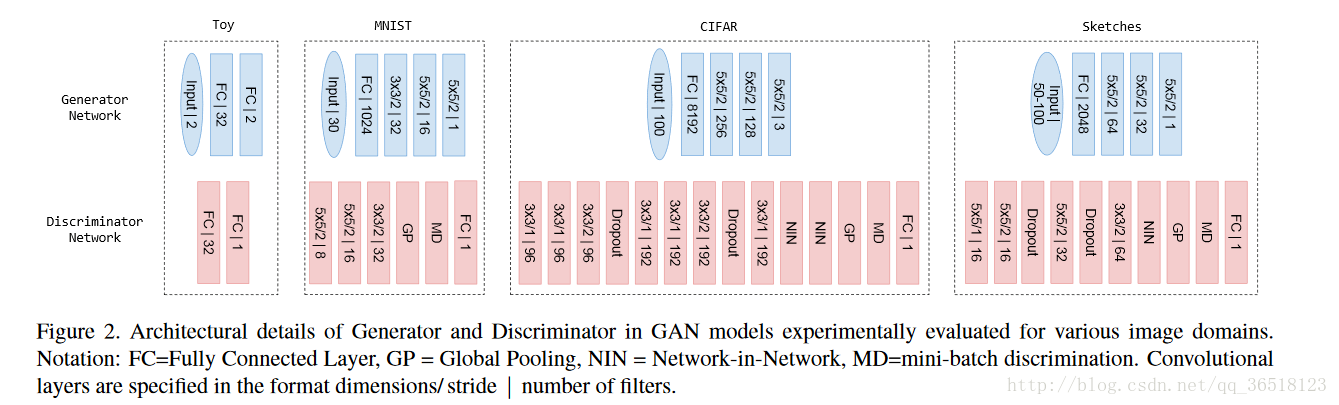

这个论文实验最有意思的地方在于他对不同的数据库用不同的架构

可以看出,他用了Inceptive的结构,这对于某些网络结构有非常好的效果。

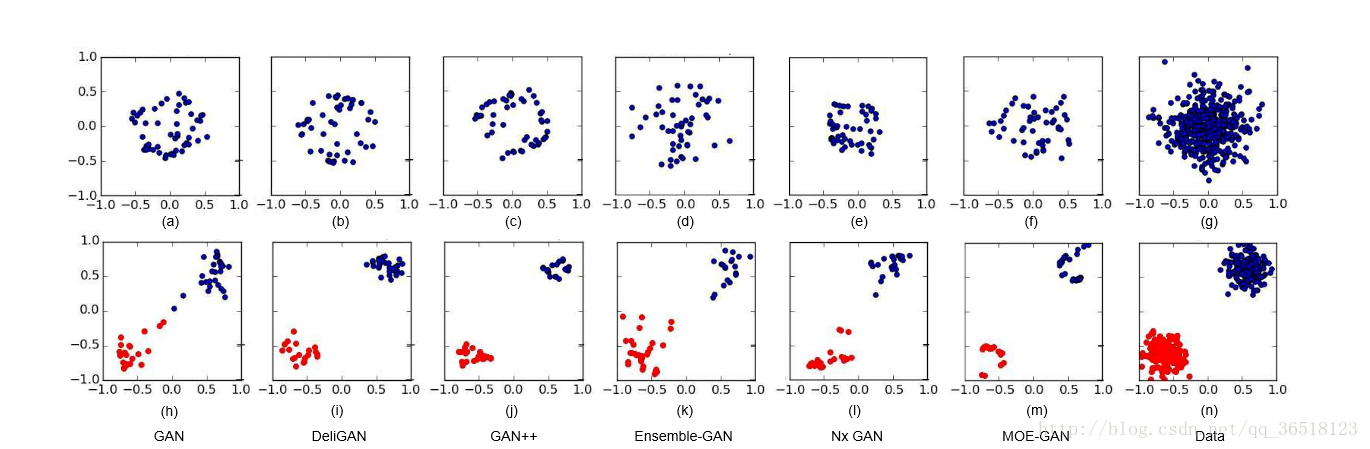

从h-m中看出,效果大概比GAN好(j-m是它定义的一些架构,就不描述了)

- 我的想法

我觉得……还行吧,暂时没有运行过。整体比较玄学,并没有解释为什么这个设计好与好在哪,我只能说输入从普通的高斯噪音变成了加强版的高斯输出

我认为单元的设计有点像Dropout + ensemble。

我懂为什么对多样性有帮助,但是并不是很懂对limited data有什么帮助